Sistemas HGX H200 e instâncias de nuvem estarão em breve disponíveis nos principais fabricantes de servidores e provedores de serviços de nuvem do mundo

A NVIDIA anuncia que potencializou a plataforma de computação de IA líder mundial com o lançamento da NVIDIA HGX™ H200. Baseada na arquitetura NVIDIA Hopper™, a plataforma apresenta a GPU NVIDIA H200 Tensor Core com memória avançada para lidar com grandes quantidades de dados para IA generativa e cargas de trabalho de computação de alto desempenho.

A NVIDIA H200 é a primeira GPU a oferecer HBM3e – memória maior e mais rápida para alimentar a aceleração de IA generativa e grandes modelos de linguagem, ao mesmo tempo que avança a computação científica para cargas de trabalho de HPC. Com o HBM3e, a NVIDIA H200 oferece 141 GB de memória a 4,8 terabytes por segundo, quase o dobro da capacidade e 2,4x mais largura de banda em comparação com seu antecessor, o NVIDIA A100.

Espera-se que os sistemas equipados com H200 dos principais fabricantes de servidores e provedores de serviços em nuvem do mundo comecem a ser comercializados no segundo trimestre de 2024.

“Para criar inteligência com aplicações generativas de IA e HPC, grandes quantidades de dados devem ser processadas de forma eficiente e em alta velocidade usando memória de GPU grande e rápida”, diz Ian Buck, vice-presidente de hiperescala e HPC da NVIDIA. “Com a NVIDIA H200, a plataforma de supercomputação de IA ponta a ponta líder do setor ficou mais rápida para resolver alguns dos desafios mais importantes do mundo.”

Inovação perpétua, saltos perpétuos de desempenho

A arquitetura NVIDIA Hopper oferece um salto de desempenho sem precedentes em relação a sua antecessora e continua a elevar o padrão por meio de melhorias contínuas de software com a H100, incluindo o recente lançamento de poderosas bibliotecas de código aberto como NVIDIA TensorRT™-LLM.

A introdução da H200 levará a mais saltos de desempenho, incluindo quase o dobro da velocidade de inferência no Llama 2, um LLM de 70 bilhões de parâmetros, em comparação com a H100. Espera-se liderança adicional de desempenho e melhorias com a H200 em futuras atualizações de software.

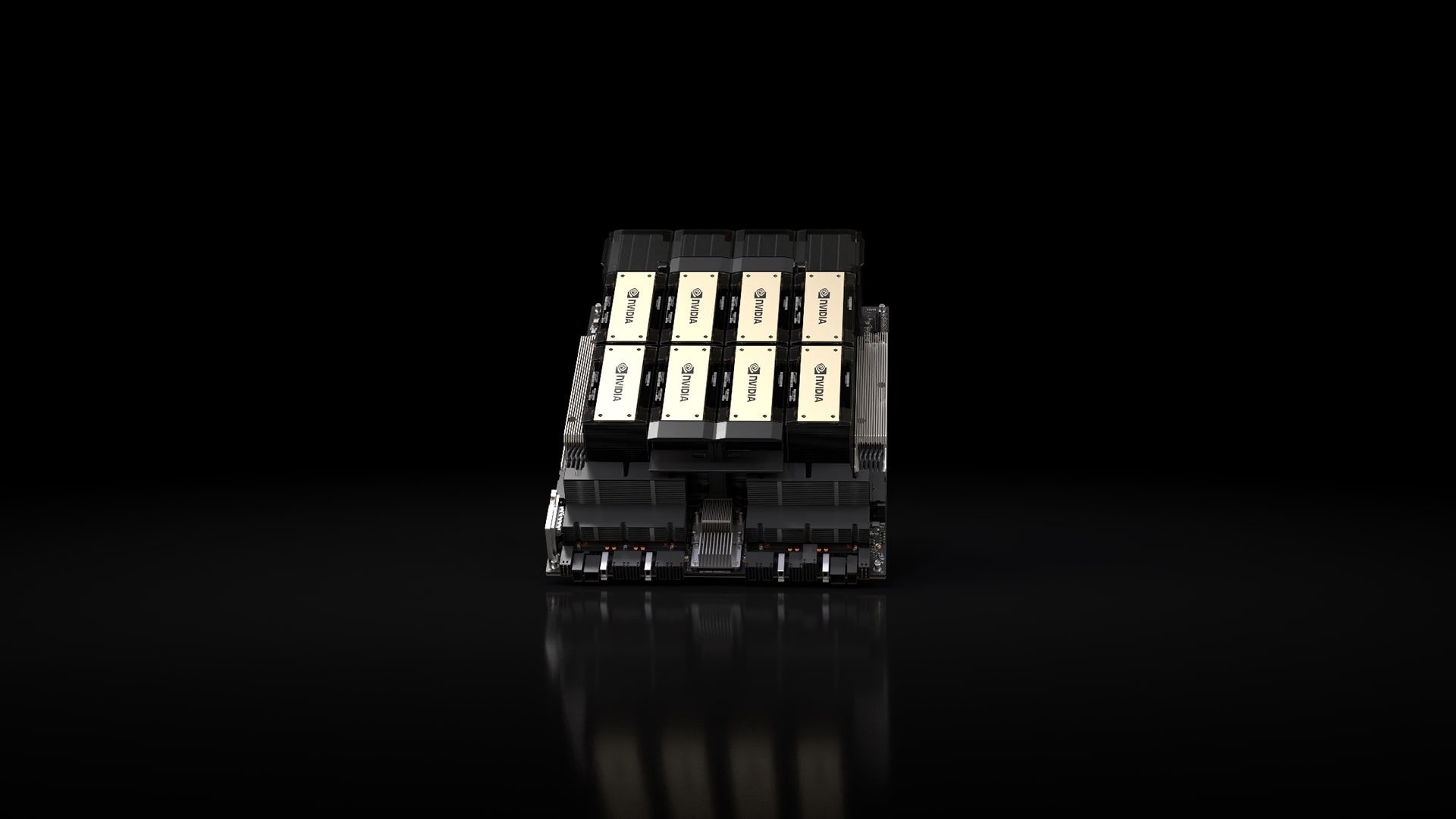

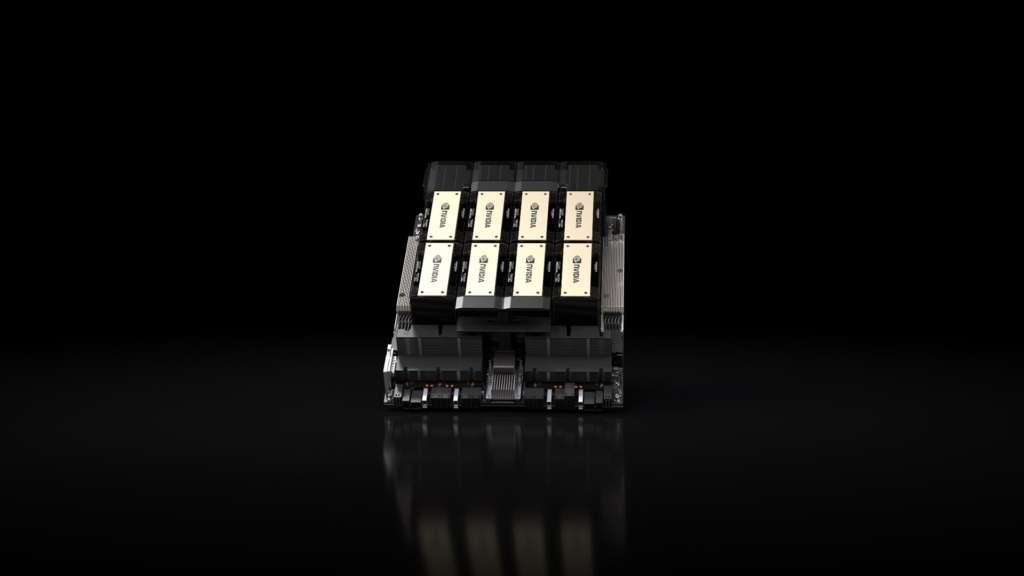

Fatores de forma NVIDIA H200

NVIDIA H200 estará disponível em placas para servidores NVIDIA HGX H200 com configurações de quatro e oito vias, que são compatíveis com hardware e software dos sistemas HGX H100. Também está disponível no Superchip NVIDIA GH200 Grace Hopper™ com HBM3e, anunciado em agosto.

Com essas opções, a H200 pode ser implantado em qualquer tipo de data center, incluindo local, nuvem, nuvem híbrida e borda. O ecossistema global de fabricantes de servidores parceiros da NVIDIA – incluindo ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron e Wiwynn – podem atualizar seus sistemas existentes com um H200.

Amazon Web Services, Google Cloud, Microsoft Azure e Oracle Cloud Infrastructure estarão entre os primeiros provedores de serviços em nuvem a implantar instâncias baseadas em H200 a partir do próximo ano, além de CoreWeave, Lambda e Vultr.

Equipado com interconexões de alta velocidade NVIDIA NVLink™ e NVSwitch™, a HGX H200 oferece o mais alto desempenho em diversas cargas de trabalho de aplicações, incluindo treinamento LLM e inferência para os maiores modelos, além de 175 bilhões de parâmetros.

Uma HGX H200 de oito vias fornece mais de 32 petaflops de computação de deep learning FP8 e 1,1 TB de memória agregada de alta largura de banda para o mais alto desempenho em aplicações generativas de IA e HPC.

Quando combinado com CPUs NVIDIA Grace™ com interconexão NVLink-C2C ultrarrápida, a H200 cria a GH200 Grace Hopper Superchip com HBM3e — um módulo integrado projetado para atender aplicações de HPC e IA em escala gigante.

“Com a crescente quantidade de dados a serem explorados, torna-se imperativo investir em maior capacidade de processamento. Essa é exatamente a proposta que a NVIDIA apresenta com o lançamento atual, oferecendo uma solução que promete proporcionar ainda mais velocidade e escalabilidade para as empresas que a adotarem”, destaca Marcio Aguiar, diretor da divisão Enterprise da NVIDIA para América Latina.

Acelere a IA com o software NVIDIA Full Stack

A plataforma de computação acelerada da NVIDIA é suportada por ferramentas de software poderosas que permitem que desenvolvedores e empresas criem e acelerem aplicações prontas para produção, desde IA até HPC. Isso inclui o pacote de software NVIDIA AI Enterprise para cargas de trabalho como fala, sistemas de recomendação e inferência de hiperescala.

Disponibilidade

A NVIDIA H200 estará disponível em fabricantes globais de sistemas e provedores de serviços em nuvem a partir do segundo trimestre de 2024.

Leonnah

Ultimos posts por Leonnah (ver todos)

- TEKKEN 8 revela nova personagem Reina - 14 de novembro de 2023

- NVIDIA potencializa Hopper, a plataforma de computação de IA líder mundial. - 14 de novembro de 2023

- Alan Wake 2 e Baldur’s Gate 3 lideram indicações para o The Game Awards 2023. - 14 de novembro de 2023